Tantangan golf neural net sebelumnya ( ini dan itu ) menginspirasi saya untuk mengajukan tantangan baru:

Tantangan

Temukan jaringan neural feedforward terkecil sehingga, diberikan setiap vektor input 4-dimensi dengan entri integer di , output jaringan dengan kesalahan koordinat-bijaksana benar-benar lebih kecil dari .

Tidak dapat diterima

Untuk tantangan ini, jaringan saraf umpan maju didefinisikan sebagai komposisi lapisan . Lapisan adalah fungsi yang ditentukan oleh matriks dari bobot , vektor dari bias , dan fungsi aktivasi yang diterapkan coordinate- bijaksana:

Since activation functions can be tuned for any given task, we need to restrict the class of activation functions to keep this challenge interesting. The following activation functions are permitted:

Identity.

ReLU.

Softplus.

Hyperbolic tangent.

Sigmoid.

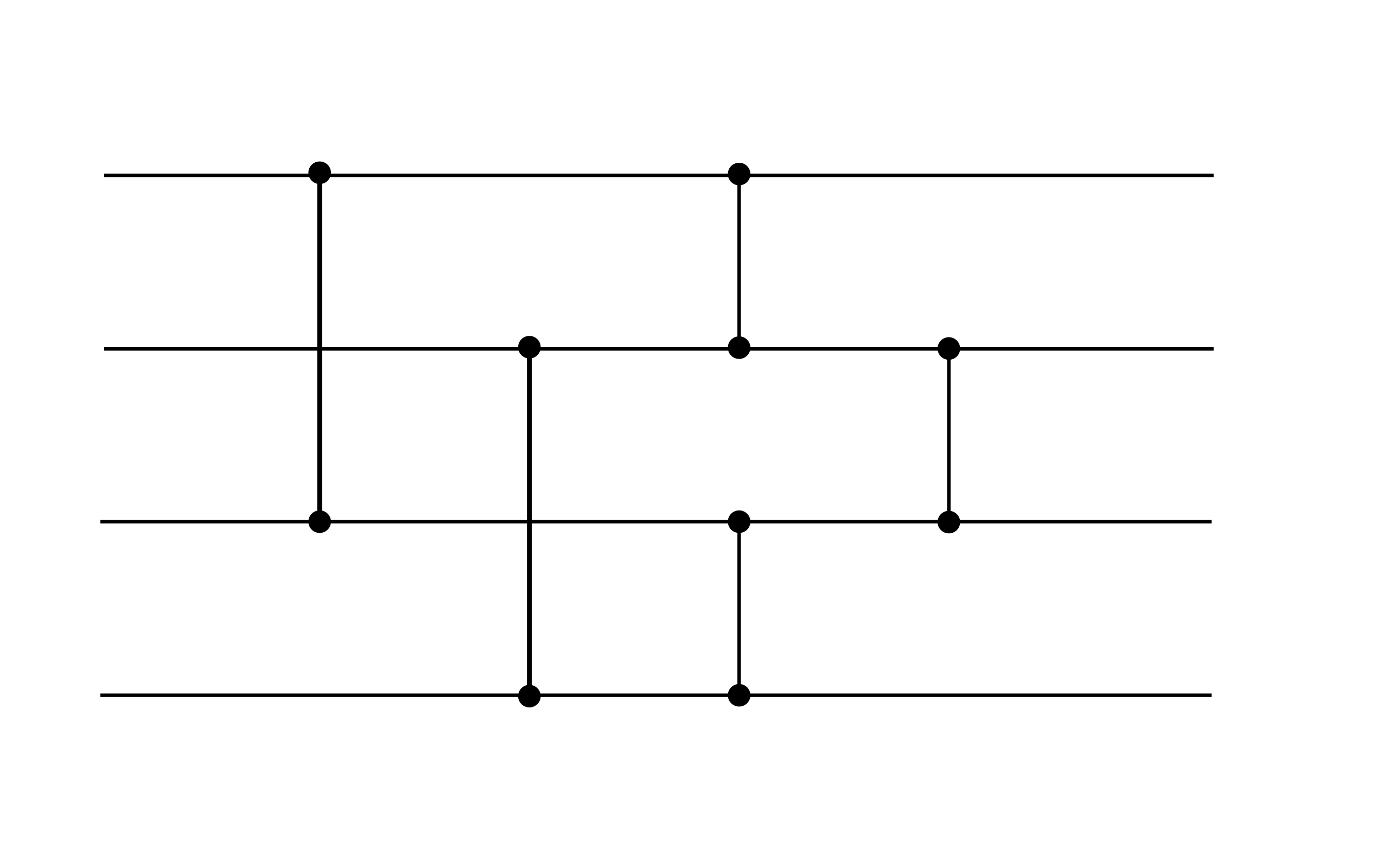

Secara keseluruhan, sebuah jaring saraf yang dapat diterima mengambil bentuk untuk beberapa , di mana setiap lapisan ditentukan oleh bobot , bias , dan fungsi aktivasi dari daftar di atas. Misalnya, jaring saraf berikut ini dapat diterima (meskipun tidak memenuhi tujuan kinerja dari tantangan ini, itu mungkin merupakan gadget yang berguna):

Contoh ini menunjukkan dua lapisan. Kedua lapisan memiliki bias nol. Lapisan pertama menggunakan aktivasi ReLU, sedangkan yang kedua menggunakan aktivasi identitas.

Mencetak gol

Your score is the total number of nonzero weights and biases.

(E.g., the above example has a score of 16 since the bias vectors are zero.)